Скреперы фото: Скрепер прицепной (Scraper): принцип работы, характеристики

Скрепер прицепной (Scraper): принцип работы, характеристики

Прицепной скрепер – техника специализированного назначения, способная выполнять землеройные работы и доставлять изъятый с площадки грунт в место отсыпки. Также эти машины выравнивают и уплотняют почву в зоне проведения мероприятий. Прицепные скреперы, в отличие от самоходных, могут применяться исключительно в паре с тягачом или трактором. Полный цикл работы техники объединяет процессы послойного резания почвы, накопления грунта в специальном ковше, транспортировки, выгрузки и возврата. Дальность перемещения породы у машин такого типа составляет 0,5…1 км. Наиболее эффективным считается их применение в зонах с супесными и суглинистыми почвами. Также прицепной скрепер хорошо справляется с обработкой грунта 1–4-й категорий, в том числе тяжелой глины, черноземов и скальных пород.

Принцип работы и преимущества

Прицепной скрепер имеет простую схему функционирования. Перед началом движения ковш приводится в рабочее состояние: заслонка поднимается на определенную высоту, за счет чего между ножами и нижней кромкой образуется щель, и заглубляется в грунт.

Прицепные скреперы характеризуются следующими преимуществами:

- возможностью использования с разными видами тракторов и тягачей;

- большой силой тяги, обеспечивающей высокую производительность;

- отличной проходимостью по бездорожью и другим сложным участкам;

- самостоятельной загрузкой ковша и быстрой выгрузкой;

- способностью эффективно работать в любых грунтовых и климатических условиях.

Особенности эксплуатации прицепных скреперов

- Современные модели спецтехники данного типа наиболее эффективно проявляют себя при обустройстве котлованов и траншей глубиной до 5–7 м. Причем за один проход скреперы в среднем могут снимать слой грунта толщиной 60–70 см.

- Разработка песчаных, лессовых, супесчаных и прочих малосвязных почв осуществляется траншейным способом. То есть техника проходит несколько раз по одному следу. При этом общая глубина траншеи может превышать 0,5 м.

- Оптимальный уровень заполнения ковша достигается при обработке грунтов влажностью 25 %. Если почва слишком сухая, ее предварительно увлажняют поливочными машинами. Орошение проводится в несколько этапов по мере разработки участка.

- Резание глинистых, суглинистых и других плотных грунтов осуществляется стружкой длиной 6–8 см. Чрезмерно тяжелую почву предварительно рыхлят бульдозерами до образования комьев диаметром не меньше 10–15 см. Излишнее измельчение ухудшает наполнение ковша.

- В процессе земляных работ буксируемые скреперы могут использоваться в составе механизированной колонны. Часто их встраивают в цепочку машин, выполняющих однотипные действия, например с автогрейдерами, катками или бульдозерами.

- Замерзший грунт существенно усложняет обработку территории. Использование скреперов возможно только в котлованах, которые были предварительно защищены от промерзания. Также зимой эту технику можно использовать для создания насыпей из несвязных грунтов.

- Транспортировка почвы скрепером должна осуществляться по подготовленным дорогам или специальным отсыпанным проездам. На пути движения техники не должно быть крутых поворотов и труднопреодолимых возвышений.

Устройство и основные части

Все модели современных прицепных скреперов имеют примерно одинаковую конструкцию. Данные машины представлены агрегатами с мощным колесным шасси, тяговой рамой с хоботной балкой, большим и функциональным ковшом, а также системой управления.

- Серьга – специальный узел, выполняющий передаточную функцию при соединении скрепера с трактором или тягачом.

- Ходовая часть – представлена двухосным шасси с пневматическими колесами, способными легко перемещаться по любой поверхности.

- Ковш – представлен сварным кузовом открытого или закрытого типа. Оснащен ножами, регулируемой заслонкой и подвижной задней стенкой, обеспечивающей принудительную выгрузку содержимого.

- Ножи – монтируются на специальной подножевой плите, которая, в свою очередь, фиксируется на передней кромке ковша.

- Шкворневое устройство – представлено механизмом шарового типа, который обеспечивает поворот колесной оси относительно рамы.

Параметры классификации прицепных скреперов

Обладая практически идентичным устройством, современные модели этой землеройной техники различаются между собой по ряду параметров. Варианты конструкции и функциональных возможностей позволяют выбирать наиболее подходящую машину в соответствии с условиями эксплуатации: объемом работ, вязкостью, плотностью, твердостью грунта и др. Классификация прицепных скреперов производится по следующим показателям:

Варианты конструкции и функциональных возможностей позволяют выбирать наиболее подходящую машину в соответствии с условиями эксплуатации: объемом работ, вязкостью, плотностью, твердостью грунта и др. Классификация прицепных скреперов производится по следующим показателям:

- по объему ковша. По данному критерию агрегаты разделяются на модели малой (до 5 м3), средней (5–15 м3) и большой (свыше 15 м3) вместительности;

- способу загрузки. Наиболее распространенный вариант – подпор срезанного грунта. Также есть модели со шнековой и элеваторной загрузкой;

- методу выгрузки. Принудительная осуществляется за счет выдвижения задней стенки. Также выгрузка может быть самосвальной – путем опрокидывания ковша;

- типу управления исполнительными органами. Контроль над положением и функционированием рабочих элементов может осуществляться гидравлическим, механическим (канатно-блочным) или электрогидравлическим способом;

- конструкции ковша.

Этот элемент скрепера бывает закрытого и открытого типа, одно- или двустворчатым. Также выделяют телескопические и грейферные варианты ковшей.

Этот элемент скрепера бывает закрытого и открытого типа, одно- или двустворчатым. Также выделяют телескопические и грейферные варианты ковшей.

Ключевые технические характеристики

При выборе буксируемого скрепера должны учитываться объемы и специфика запланированных земляных работ, а также особенности местного рельефа и свойства обрабатываемой почвы. Основными параметрами прицепного скрепера являются:

- тип базового трактора или тягача,

- мощность и тяговый класс,

- максимальная скорость,

- вместительность ковша,

- грузоподъемность,

- ширина резания почвы,

- толщина слоя отсыпки,

- уровень заглубления ножей,

- общие габариты,

- снаряженная масса.

Области применения

Прицепные скреперы имеют достаточно обширную сферу применения. Основные отрасли: горная промышленность, гидротехническое и дорожное строительство.

Прицепные скреперы незаменимы при подготовке территорий, предназначенных под промышленную или жилищную застройку. С их помощью можно планировать и обрабатывать целые кварталы. Также техника хорошо зарекомендовала себя в процессе:

- возведения земляных насыпей разного назначения,

- разработки широких траншей под трубопроводы,

- выемки грунта в местах обустройства искусственных водоемов,

- выравнивания дорожных покрытий от снежно-грунтовых масс,

- очищения поверхностей ото льда и отвердевшего снега.

технические характеристики, классификация, модельный ряд

Разместите заявку на покупку техники или запчастей для спецтехники!

отправить заявкуВаша заявка отправлена.

Сегодня выпуском скреперов занимается ограниченное число производителей (и сразу отметим, что основные объемы производства приходятся на североамериканские компании). В целом можно констатировать падение спроса на данный тип техники, что связано с сокращением числа новых проектов, при реализации которых скреперы традиционно принято задействовать.

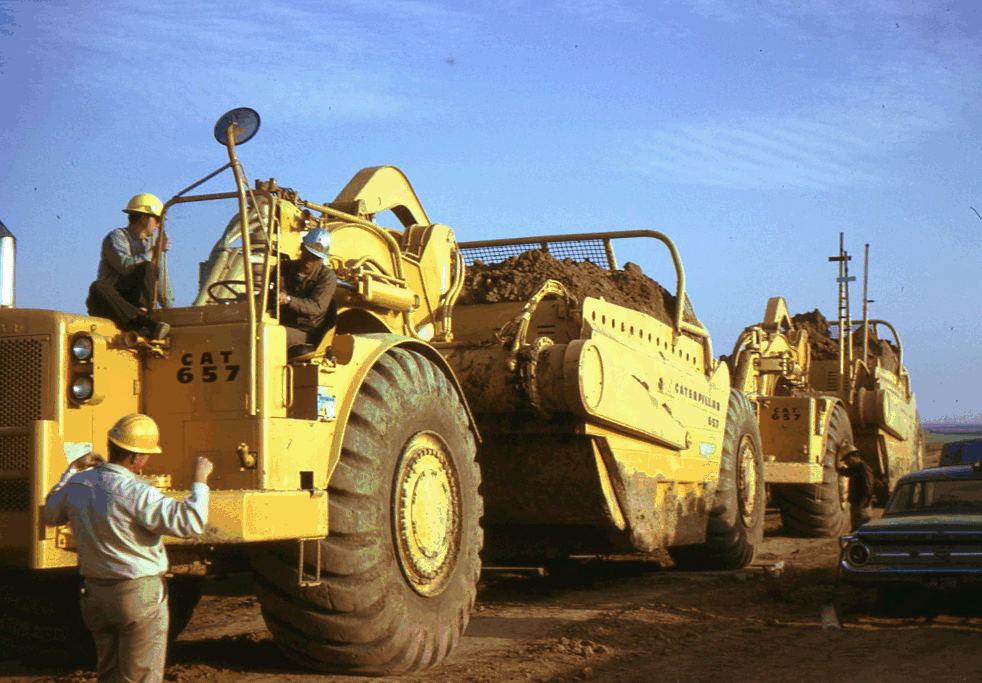

Источник фото: cat.comНазначение скреперов – послойное срезание грунта и его транспортировка

Назначение

Основная область использования скреперов – масштабные стройки с большими объемами земляных работ (включая дорожное и гидротехническое строительство), а также добыча полезных ископаемых отрытым способом. С помощью данного типа техники возможно непосредственно выполнять разработку грунтов I и II категории. Почвы III и IV категорий требуется предварительно разрыхлять. На заболоченных или несвязных переувлажненных почвах, а также в местах с большими каменистыми включениями производить операции скрепером не рекомендуется. При этом основной рабочей функцией машин можно назвать отсыпку почвы в насыпи, дополнительной – уплотнение задними колесами свежеотсыпанного материала.

На заболоченных или несвязных переувлажненных почвах, а также в местах с большими каменистыми включениями производить операции скрепером не рекомендуется. При этом основной рабочей функцией машин можно назвать отсыпку почвы в насыпи, дополнительной – уплотнение задними колесами свежеотсыпанного материала.

Являясь машиной циклического действия, скрепер последовательно выполняет следующие операции: копание, доставка набранного материала к месту укладки с последующей его выгрузкой, перемещение в точку начала следующего цикла. Основным рабочим органом машины является скреперный ковш, который опускают в почву с помощью гидроцилиндров. Срезание грунта выполняется послойно.

Классификация

Продолжая тему рабочего процесса, скажем, что скреперы можно классифицировать в зависимости от способа загрузки и выгрузки материала. Наполнение ковша может осуществляться с помощью загрузочного устройства элеваторного или шнекового типа. Третий вариант – тяговый (за счет подпора грунта). Для выгрузки в свою очередь используется один из следующих методов: рабочий орган опрокидывается (данная операция может выполняться вперед или назад), материал выталкивается с помощью задней стенки, путем раздвижения днища и т.д.

Для выгрузки в свою очередь используется один из следующих методов: рабочий орган опрокидывается (данная операция может выполняться вперед или назад), материал выталкивается с помощью задней стенки, путем раздвижения днища и т.д.

Источник фото: deere.comКлассификация скреперов. Один из видов – прицепные модели

Следующий критерий классификации – способ передвижения. На рынке доступны следующие варианты:

- Самоходные скреперы. Данный тип подразделяется на двух- и трехосные модели, доступна техника с одним или двумя моторами. В последнем случае силовая установка размещена не только на переднем модуле, но и на заднем мосту, благодаря чему сцепная масса машины используется более эффективно.

- Прицепные скреперы. Это преимущественно оборудование с двумя осями. Привод рабочих органов может осуществляться или от гидросистемы тягача, или от лебедки, расположенной на тяговом средстве (привод от вала отбора мощности). Скорость движения у данных машин довольно низкая.

- Полуприцепные скреперы – оборудование с одной осью, передняя часть опирается на базовую машину (а конкретно – на тягово-сцепное устройство). В отличие от прицепных моделей, в данном случае часть силы тяжести рабочего оборудования, наполненного грунтом, передается на тягач, а не только на опорную поверхность через собственные ходовые устройства.

Задние колеса скреперов большой вместимости (объем ковша более 15 куб.м) могут быть приводными: в них встраивают электрический или гидравлический привод (так называемое мотор-колесо). Также доступные на рынке модели отличаются друг от друга устройством заслонок, конструкцией ковша, приводом исполнительных органов (модели с канатным или гидравлическим управлением) и т.д.

Источник фото: belaz.byОдно из преимуществ скреперов – возможность работать с большими объемами материала

Преимущества различных методов выполнения работ

Землеройные операции с помощью скрепера можно выполнять клиновым способом (наиболее эффективен на связных грунтах), гребенчатым (дает удовлетворительные результаты на суглинистых и глинистых почвах) и клевковым (достаточная производительность на сухих песках и супесях). Преимуществом первого метода является использование резерва тяги в течение всего цикла разработки, а не только в его конце.

Преимуществом первого метода является использование резерва тяги в течение всего цикла разработки, а не только в его конце.

Достоинством скреперов с элеваторной или шнековой загрузкой является увеличенная заполняемость ковша без использования толкача (в среднем производительность улучшается на 20%), а также повышение качества отсыпанного грунта. Но нужно иметь в виду, что и конструкция у такого оборудования более сложная.

В случае использования толкачей можно увеличить толщину стружки до 40%: оборудованный буферами трактор или бульдозер заходит в хвост скрепера и сообщает ему дополнительное тяговое усилие. Один толкач способен обслуживать на рабочей площадке сразу до 16 машин.

Еще один метод производства работ – формирование поездов из двух скреперов: машины соединяются управляемым сцепным устройством, благодаря чему для последовательного наполнения ковшей используется удвоенное тяговое усилие.

Источник фото: cat.comТакая техническая характеристика, как производительность, повышается при формировании из двух скреперов поездов

Технические характеристики

В зависимости от типа скрепера отличается рекомендуемая дальность транспортировки грунта: для прицепных моделей данный показатель варьируется от 0,5 до 1 км, самоходных – от 1,5 до 3 км. В зависимости от объема скреперного ковша выделяют оборудование с малой вместимостью (до 5 кубических метров), средней (5-15 куб.м) и высокой (более 15 куб.м), при этом максимальное значение достигает 46 кубических метров. Отметим также, что в спецификациях могут указывать геометрическую вместимость ковша, а также заполнение “с шапкой”.

В зависимости от объема скреперного ковша выделяют оборудование с малой вместимостью (до 5 кубических метров), средней (5-15 куб.м) и высокой (более 15 куб.м), при этом максимальное значение достигает 46 кубических метров. Отметим также, что в спецификациях могут указывать геометрическую вместимость ковша, а также заполнение “с шапкой”.

Рабочая глубина зависит от типа грунта, а эффективность всего процесса будет выше при движении машины под уклон. При управлении гружеными скреперами нужно помнить, что они способны преодолевать уклоны до 12-15%, оборудование с порожним ковшом – до 15-17% (речь идет о движении в транспортном режиме). Значения крутизны спусков достигают 20-30%. Если же необходимо осуществить подъем на больший угол, то на помощь приходят толкачи.

Еще один показатель – удельный расход энергии – составляет 3,2-6 кВт*ч/куб.м. При этом наиболее энергоемкой операцией является непосредственно копание.

Видео

youtube.com/embed/umBMVB43ljs”/>

Видео с канала “ТЕХНОМИР”

Популярные марки скреперов

Скрепер / Всё об асфальтировании и дорожном строительстве. Асфальтирование Киев

Общие сведения о скрепере

Скрепер — землеройно-транспортная машина циклического действия, предназначенная для проведения земляных работ связанных с послойным (горизонтальными слоями) резанием грунта, его транспортировкой на расстояние от 150 до 5000 метров и выгрузкой слоями заданной толщины в земляное сооружение или отвал.

Главным рабочим органом скрепера является открытый спереди и сверху металлический ковш с передней режущей кромкой, укрепленный на раме с пневмоколесных ходом.

Скреперист — машинист 5-6 разряда (в зависимости от типа скрепера) осуществляющий управление скрепером. Скреперирование — процесс проведения земляных работ при помощи скреперной техники.

Цикл работы скрепера состоит из следующих операций выполняемых последовательно:

- Наполнение ковша грунтом путем его послойного срезания.

Ковш скрепера загружается напорным усилием в процессе движения машины. В самом конце процесса загрузки, когда ковш почти полностью заполнен грунтом, а процесс срезания слоя продолжается, тягового усилия базовой машины может быть недостаточно и для полной загрузки ковша используется трактор-толкач, который своим отвалом упирается в буфер скрепера передавая ему дополнительное тяговое усилие, необходимое для полной загрузки ковша грунтом.

Ковш скрепера загружается напорным усилием в процессе движения машины. В самом конце процесса загрузки, когда ковш почти полностью заполнен грунтом, а процесс срезания слоя продолжается, тягового усилия базовой машины может быть недостаточно и для полной загрузки ковша используется трактор-толкач, который своим отвалом упирается в буфер скрепера передавая ему дополнительное тяговое усилие, необходимое для полной загрузки ковша грунтом. - Транспортирование груженого скрепера к месту выгрузки. При транспортировании грунта ковш скрепера переводится в транспортное положение поднимаясь над поверхностью грунта на 40–50 см.

- Разгрузка. Процесс выгрузки грунта из ковша осуществляется в процессе движения машины.

- Транспортирование пустой машины в забой. По окончании разгрузки скреперный ковш снова устанавливается в транспортное положение и машина направляется для выполнения очередного цикла работ.

Назначение и область применения скреперной техники

Функциональным назначением скрепера является:

- Разработка грунтов I–IV категории путем послойного срезания с набором в ковш.

Толщина срезаемого слоя грунта может варьироваться от 15 до 60 см в зависимости от категории грунта и типа скрепера.

Толщина срезаемого слоя грунта может варьироваться от 15 до 60 см в зависимости от категории грунта и типа скрепера. - Транспортирование грунта к месту выгрузки на расстояние от 150 до 5000 метров (до 150 метров используются бульдозеры, более 5000 метров — автосамосвалы).

- Отсыпка грунта слоями путем выгрузки из ковша.

- Разравнивание и планировка площадок.

Скреперные работы подразделяют на основные и вспомогательные. К основным работам относится разработка больших объемов грунтовых масс и их перемещение в земляное сооружение. К вспомогательным — удаление растительного слоя грунта, транспортирование сыпучих грузов и планировочные работы.

Скреперы не используются (по причине низкой эффективности) для разработки сухих сыпучих и тяжелых глинистых грунтов, а также грунтов с крупными каменистыми включениями, наличием пней и крупных корней деревьев. Также скреперы не применяются на влажных и липких грунтах, заболоченных участках. Разработка скреперами грунтов III–IV категории и мерзлых грунтов осуществляется после предварительного рыхления.

Разработка скреперами грунтов III–IV категории и мерзлых грунтов осуществляется после предварительного рыхления.

Различные виды скреперов широко применяются в дорожном (при строительстве, реконструкции и подготовке дорог к последующему асфальтированию), гражданском, промышленном и гидротехническом строительстве, а также в сельском и лесном хозяйстве. В гражданском и промышленном строительстве скреперы используются при подготовке территорий под застройку, планировке кварталов, возведении насыпей, разработке широких траншей и выемок, при разработке больших котлованов для подземных частей промышленных объектов.

В дорожно-строительной отрасли скрепер применяется при строительстве новых автомобильных дорог, а также при реконструкции и капитальном ремонте старых дорожных одежд. При строительстве и реконструкции автомобильных дорог скреперы используются на начальном этапе дорожных работ связанных с подготовкой земляного полотна (профилирование и планировка грунта, удаление с поверхности материкового грунта растительного слоя и т. д.).

д.).

Данный этап является одним из важнейших во всем цикле дорожно-строительных работ, т. к. земляное полотно автомобильной дороги призвано обеспечивать устойчивость всей дорожной конструкции при действии транспортных нагрузок и сохранять в процессе эксплуатации предусмотренные проектом размеры и профиль дороги. Стабильность грунтового слоя и общее качество проведения земляных работ определяют долговечность, а также транпортно-эксплуатационные характеристики дорожного полотна не в меньшей степени чем качество верхних асфальтированных слоев дорожного покрытия (непосредственно воспринимающих нагрузку от транспорта).

Классификация скреперов

По способу передвижения

- Самоходный — скрепер, у которого конструктивный вес и вес грунта в ковше передается на опорную поверхность через ходовую часть (как правило, колеса, реже гусеницы). Используются, при необходимости перемещения грунта на расстояние от 500 до 5000 метров. Самоходные скреперы отличаются высокой транспортной скоростью и мобильностью (по сравнению с другими типами скреперов).

- Прицепной — скрепер, буксируемый гусеничным или колесным трактором. В прицепном скрепере вся весовая нагрузка (конструктивный вес и вес грунта в ковше) передается на опорную поверхность через колеса. Данный тип скреперов применяется, как правило, для транспортирования грунта на расстояние от 200 до 500 метров. Скреперы агрегатируемые с колесным трактором, а не с гусеничным, могут использоваться для транспортировки грунта на расстояние более 500 метров.

- Полуприцепной — скрепер, буксируемый гусеничным или колесным трактором. В отличие от прицепного скрепера, в котором вся весовая нагрузка (конструктивный вес и вес грунта в ковше) передается на опорную поверхность колес скрепера, в полуприцепном часть весовой нагрузки передается на трактор-тягач через сцепное устройство.

- Спаренный — скреперный поезд, представляющий собой 2–3 скреперных агрегата (самоходных, прицепных и/или полуприцепных) соединенных вместе и работающих как единое целое.

По типу ходовой части

- Пневмоколесный

- Гусеничный

По емкости скреперного ковша

- Малой емкости (до 5 м3)

- Средней емкости (свыше 5 до 15 м3)

- Большой емкости (свыше 15 м3)

По способу загрузки ковша

- С пассивной загрузкой.

Наполнение скреперного ковша грунтом осуществляется за счет движущего усилия срезаемого слоя при движении машины.

Наполнение скреперного ковша грунтом осуществляется за счет движущего усилия срезаемого слоя при движении машины. - С принудительной (активной) загрузкой. Скреперы с принудительной загрузкой отличаются пониженной на 30-60 % силой тяги, необходимой для загрузки ковша и поэтому могут обходиться без дополнительного толкача. С другой стороны, наличие загрузочного устройства внутри ковша (элеватора или роторного шнека) снижает надежность техники, усложняет ее эксплуатацию и повышает стоимость обслуживания.

- С элеваторной загрузкой. Вместо передней заслонки устанавливается скребковый конвейер, благодаря чему, помимо частичного заполнения ковша обычным способом, грунт подается в ковш также и скребками элеватора. Скреперы с элеваторной загрузкой могут использоваться для проведения земляных работ на любых грунтах, однако на каменистых и переувлажненных почвах их эффективность резко снижается.

- С роторным шнеком. Шнекороторные скреперы с принудительной загрузкой используются для скреперирования крупнообломочных, каменистых и сыпучих грунтов.

По способу разгрузки ковша

- Со свободной разгрузкой. Скрепер разгружается путем опрокидывания ковша вперед или назад с помощью канатного или гидравлического привода под действием силы тяжести. К преимуществам свободной разгрузки можно отнести простоту конструкции таких скреперов, а к недостаткам — неполную разгрузку ковша при работе на влажных и липких грунтах.

- С принудительной разгрузкой. В скреперах с принудительной разгрузкой заднюю стенку ковша выполняют подвижной и выгрузка грунта осуществляется путем выдвижения ее вперед. К преимуществам скреперов с принудительной разгрузкой можно отнести полную выгрузку грунта из ковша даже при работе на влажных и липких грунтах, к недостаткам — более сложную конструкцию ковша.

- С полупринудительной разгрузкой. В скреперах с полупринудительной разгрузкой днище ковша и его задняя стенка представляют собой единую конструкцию, которая крепится шарнирно к боковым стенкам. При разгрузке ковша днище и задняя стенка выдвигаются вперед, а боковые стенки остаются неподвижными.

Недостатком скреперов с полупринудительной разгрузкой является неполная разгрузка ковша при работе на влажных и липких грунтах.

Недостатком скреперов с полупринудительной разгрузкой является неполная разгрузка ковша при работе на влажных и липких грунтах.

По способу управления рабочим оборудованием

- С гидравлическим управлением

- С электрогидравлическим управлением

- С канатным управлением

- С канатно-электрическим управлением

Выбор конкретного типа скрепера для проведения земляных работ определяется видом грунта, рельефом местности, объемом и глубиной земляных выработок, а также дальностью перемещения грунта.

Основные эксплуатационные характеристики скрепера

- Эксплуатационная масса, кг

- Габаритные размеры, мм

- Геометрическая вместимость скреперного ковша, м3

- Номинальная вместимость скреперного ковша, м3

- Ширина и толщина отсыпаемого слоя грунта, см

- Рабочая и транспортная скорость, км/ч

- Наибольший преодолеваемый подъем, °

- Радиус поворота, м

Скреперы – технические характеристики, описание, схемы, фото, видео | Hard-Machines.

ru

ruЗемельно-транспортная машина скрепер предназначена для послойного вскапывания грунтов, их перевозки и отсыпки слоями нужной толщины в земляное сооружение. Скрепером разрабатывают грунт 1-2 категории (от чернозема до тяжелых глин). Если грунт более плотной категории он разрабатывается предварительно рыхлителем. Насколько результативна работа скрепера зависит от дальности перевозимого грунта.

Виды скреперов. Такая техника подразделяется на несколько основных видов: прицепной скрепер, самоходный скрепер.

1. Прицепной скрепер обычно состыкуют с гусеничным трактором в единый рабочий комплекс. Его, как правило, используют при транспортировке на дальность от 100 до 1000м. Применение прицепного скрепера вполне целесообразно при нужной вместимости и быстроходности. Если же транспортировка предполагает расстояние свыше одного километра, то самосвал становится рентабельнее скрепера.

2. Самоходный скрепер является внедорожным транспортным средством. Его используют на грунтовых и карьерных дорогах. Цель применения самоходного скрепера это скорее пересечь нулевой цикл земельных работ и подготовить площадь к передаче для дальнейшего строительства. Такую технику компонуют, как правило, с быстроходными тягачами. Его рентабельная дальность транспортировки составляет обычно от 300 до 3000м.

Цель применения самоходного скрепера это скорее пересечь нулевой цикл земельных работ и подготовить площадь к передаче для дальнейшего строительства. Такую технику компонуют, как правило, с быстроходными тягачами. Его рентабельная дальность транспортировки составляет обычно от 300 до 3000м.

Уборочный скрепер. Есть еще один прибор с названием скрепер для уборки снега. От вышеперечисленной техники он кардинально отличается своей, в общем-то, простотой и незатейливостью. Но при этом пользу скрепер для снега приносит немалую.

Этот компактный, нетяжелый инструмент с пластиковой или деревянной ручкой, с общей рабочей площадью от 70-80 см прекрасно справляется с поставленной перед ним задачей – уборкой снега.

Современные снегоуборочные скреперы часто выпускают с телескопической рукоятью, благодаря чему, рабочий может персонализировать инструмент под себя. Скреперы для снега бывают пластиковыми, бываю металлическими. Первые имеют относительно невысокую цену, вторые обладают повышенной износостойкостью, более прочны. Но в независимости от своего вида и предназначения скрепер выделяется среди другого оборудования своей мощностью и эффективностью.

Но в независимости от своего вида и предназначения скрепер выделяется среди другого оборудования своей мощностью и эффективностью.

Бульдозеры, скреперы, грейдеры для разработки грунта

24 июл 2019Бульдозеры, скреперы, грейдеры

Эффективные землеройно-транспортные работы обеспечиваются особой категорией спецтехники, к которой относятся бульдозеры, скреперы и грейдеры. Один технологический цикл обозначенного транспорта позволяет разработать грунт, транспортировать и разгрузить сыпучий материал.

Бульдозеры, скреперы, грейдеры: отличительные особенности

Среди данных машин наиболее мощными характеристиками обладают скреперы. Они активно применяются для реализации крупномасштабных земельно-транспортных операций – разработке котлованов, планировке откосов и поверхностей. Ключевой рабочий инструмент спецтехники – ковш с ножевой конструкцией. Он наполняется во время разрезания грунта.

Различают три вида скреперов:

Самоходные модели подходят для перевозки материала на расстояние до 3 км. Для транспортировки грунта на 1 км можно приобрести прицепные или полуприцепные скреперы. При выборе необходимо обращать внимание на вместимость ковша, ширина и глубины копания, резания.

Для транспортировки грунта на 1 км можно приобрести прицепные или полуприцепные скреперы. При выборе необходимо обращать внимание на вместимость ковша, ширина и глубины копания, резания.

Бульдозер – спецтехника для планировки откосов и поверхностей, разработки траншей и котлованов, транспортировки земли. Главный навесной модуль – отвал с ножом. Технологическая операция состоит из набора, перевозки и укладки материала. Бульдозер рационально использовать на объектах, где требуется перемещение грунта на 25-100 м.

Грейдеры позволяют решать следующие задачи:

-

профилирование грунтовой поверхности;

-

отделка земельного полотна;

-

создание невысоких насыпей и канав для отвода воды;

-

планировочные мероприятия.

Целесообразно эксплуатировать автогрейдеры для перемещения грунта на дистанцию не более 25 м. Технологический цикл включает в себя разрезание и перемещение грунта, отделочные и планировочные работы, разравнивание площадки и формирование откосов.

Технологический цикл включает в себя разрезание и перемещение грунта, отделочные и планировочные работы, разравнивание площадки и формирование откосов.

Разработка грунта бульдозерами, скреперами и грейдерами – востребованное мероприятие в строительной, лесной и дорожной промышленности. При выборе спецтехники необходимо обращать внимание не только на технологические параметры и стоимость, но и на качество сборки, комплектацию, адаптированность под климатические условия.

Бульдозеры, скреперы и грейдеры с современным дизайном, инновационными технологиями, высокой производительностью и комфортной кабиной оператора представлены на сайте компании XCMG. Все модели отличаются привлекательным соотношением цены и качества.

Скрепер

Автор: Прогресс Технологий 04.05.2019 4013 Просмотров

Скрепером, или скрейпером, называют землеройную машину, способную не только срезать грунт, но и транспортировать его на сравнительно большие (от ста метров до — в отдельных случаях — трех километров) расстояния. Кроме того, движители скрепера уплотняют отсыпанный им грунт, что сокращает потребность ведущей работы организации сразу на несколько единиц техники.

Кроме того, движители скрепера уплотняют отсыпанный им грунт, что сокращает потребность ведущей работы организации сразу на несколько единиц техники.

Будь то чернозем или тяжелые глины, скрепер аккуратно срежет грунт слоями, соберет в ковш, транспортирует в нужное место, расположенное за сотни метров, отсыпет его и сам же уплотнит. Благодаря большому числу задач, которые входят в рабочий цикл этих машин, скреперы, самоходные и прицепные, находят применение во многих отраслях строительства, включая дорожное, а также при добыче полезных ископаемых, в сельском хозяйстве и мелиорации.

Самоходный скрепер быстрее (способен развивать скорость до 40—50 километров в час), он самодостаточен и потому стоит дороже. Зато прицепной позволяет использовать в качестве тягача уже имеющуюся в хозяйстве технику — прежде всего тракторы, не занятые на момент работ другими задачами. Применение скреперов выгодно там, где требуется переместить снятый грунт на сотни метров. Если расстояние больше, для транспортировки целесообразнее применять самосвалы, загружая их экскаватором или ковшовым погрузчиком, если меньше — то гусеничные бульдозеры, а после выгрузки грунта предоставить слово уплотнительной технике. В пределах же от ста до трех тысяч метров самоходный скрепер, колесный или гусеничный, все сделает сам, без лишних помощников; для прицепных машин этого типа расстояние ограничивается тысячей метров — при этом и тот, и другой способны работать даже в условиях совершенного бездорожья.

В пределах же от ста до трех тысяч метров самоходный скрепер, колесный или гусеничный, все сделает сам, без лишних помощников; для прицепных машин этого типа расстояние ограничивается тысячей метров — при этом и тот, и другой способны работать даже в условиях совершенного бездорожья.

Ковш скрепера, куда при движении машины поступает срезанный грунт, загружается движущим усилием принудительно посредством скребкового элеватора или шнекового устройства, а выгружается путем опрокидывания ковша или выдвижения его задней стенки — привод исполнительных органов у него может быть как гидравлического типа, так и канатного.

Cамоходные скреперы, как правило, двух- или трехосные — их передняя часть может иметь одну или две оси и задняя — одну; ковш располагается впереди задней оси. На самоходные скреперы устанавливают один или два силовых агрегата — в последнем случае один из двигателей располагается впереди, а другой — на задней оси машины. На тяжелых грунтах резание грунта самоходным скрепером и наполнение ковша нередко выполняется при помощи толкача, в роли которого может выступать гусеничный трактор или колесный тягач, оснащенный специальными приспособлениями.

Прицепные скреперы — двухосные и одноосные, они подразделяются на собственно прицепные и полуприцепные. Передняя часть скрепера-полуприцепа опирается на тягово-сцепное устройство машины, играющей роль тягача, — такие скреперы, как правило, одноосные. Скреперы-прицепы чаще всего имеют две оси, между которыми располагается ковш. Прицепные скреперы соединены с гидравлической системой машины-тягача.

Иногда скреперы соединяют между собой, образуя из них своего рода автопоезда. При этом каждый скрепер, находящийся сзади, выступает для расположенного впереди в роли толкача, а самая первая машина в сцепке используется для создания тягового усилия. В международной практике проведения землеройных работ такая система получила название push-and-pull, что-то вроде «тяни-толкай», но наоборот.

Мировой рынок скреперов год от года уменьшается, та же тенденция наблюдается и на рынке отечественном. Однако в связи с реализацией в последнее десятилетие масштабных проектов скреперы, пусть и в небольшом количестве, продолжают приобретаться различными организациями — прежде всего строительными.

Одна из наиболее известных отечественных моделей — самоходный МоАЗ-6014 производства Могилевского автомобильного завода. И хотя выпуск машин этого типа заводом уже прекращен, немалое число этих скреперов сегодня по-прежнему в строю на всем постсоветском пространстве. Конструктивно МоАЗ-6014 представляет собой шарнирно-сочлененный автопоезд грузоподъемностью 16 тонн, передней частью которого выступает одноосный многоцелевой автомобильный тягач МоАЗ-6442, а задняя — полуприцеп с ковшом объемом 11 кубометров. Тягач этого скрепера оборудован мощным дизельным двигателем, двухдисковым сцеплением с пневматическим усилением, механической и дополнительной коробками передач. Ведущий мост машины оснащен рессорной подвеской с гидравлическим амортизатором, что позволяет ему развивать высокую для машин этого типа скорость до 44 км/ч. Безопасность работы водителя самоходного скрепера МоАЗ-6014 обеспечивает двухконтурная тормозная система, которая исключает возможность выхода из строя всех колесных тормозов одновременно, а также аварийный тормоз и защитный каркас над кабиной.

Скрепер МоАЗ-6014 имеет ярко выраженную дорожно-строительную специализацию и в этой сфере выступает более экономичным вариантом, чем работающие в тандеме экскаватор-погрузчик и самосвал. Его стихия — земляные работы по расчистке площадок, подготовке основания дорожного полотна и равномерной укладке песочно-щебеночной подушки асфальтового покрытия. Применение этого скрепера также экономически целесообразно при сооружении плотин, мостов, водохранилищ, но с одной оговоркой: транспортное плечо при его использовании не должно превышать двух километров. Если расстояние между местами выемки и отсыпки грунта больше, для его транспортировки целесообразнее использовать самосвалы.

Компания Caterpillar выпускает модели скреперов как с элеваторной загрузкой, так и с открытым ковшом — более универсального применения, в числе прочего используемые при строительстве дорог, мостов, плотин и аэропортов. Последние могут выполняться производителем в различной комплектации: с самозагрузкой, в прицепном варианте с загрузкой движущим усилием и собственной системой обработки материала и с загрузкой движущим усилием. Такие машины оборудованы шнековым транспортером, который обеспечивает самозагрузку широкого спектра веществ, дизельными двигателями Caterpillar с электронным управлением, технологией Acert и модульным радиатором охлаждения с 9 ребрами.

Такие машины оборудованы шнековым транспортером, который обеспечивает самозагрузку широкого спектра веществ, дизельными двигателями Caterpillar с электронным управлением, технологией Acert и модульным радиатором охлаждения с 9 ребрами.

Одна из наиболее часто используемых в дорожном строительстве моделей скреперов этой марки — Caterpillar 621K — отличается повышенным удобством технического обслуживания, защитой от превышения максимально допустимой частоты вращения коленчатого вала двигателя и улучшенным амортизатором, использующим технологию, аналогичную подвеске сиденья Cat® Advanced Ride Management. Эта машина комплектуется усовершенствованной кабиной серии K, которая гарантирует повышенный комфорт оператора и улучшенную обзорность. Кроме того, модель обладает функцией управления скоростью движения, позволяющей устанавливать желаемую скорость в зависимости от условий эксплуатации. Грузоподъемность скрепера Caterpillar 621K — 26 190 килограммов, объем ковша — 18,4 кубометра. Максимальная глубина резания скрепера — 315 миллиметров. А максимальная глубина отсыпки — 540 миллиметров. Ширина реза у этой модели составляет 3,14 метра; ее полная масса — 36 185 килограммов. Оснащенный дизельным двигателем Cat C13 Acert мощностью 413 л.с. и топливным баком емкостью 818 литров, этот скрепер способен развивать транспортную скорость до 53,9 километра в час.

Максимальная глубина резания скрепера — 315 миллиметров. А максимальная глубина отсыпки — 540 миллиметров. Ширина реза у этой модели составляет 3,14 метра; ее полная масса — 36 185 килограммов. Оснащенный дизельным двигателем Cat C13 Acert мощностью 413 л.с. и топливным баком емкостью 818 литров, этот скрепер способен развивать транспортную скорость до 53,9 километра в час.

Для работы на небольших площадях успешно используются одноосные прицепные скреперы, работающие, как правило, в тандеме с колесным трактором, который выступает в такой связке в роли тягача. Яркий представитель этого подкласса скреперной техники — модель J20 итальянского производителя Montefiori, отлично подходящая для работы с влажными и песчаными грунтами.

Одноосный прицепной J20 имеет ковш объемом 2 или 2,5 кубометра и используется с тракторами мощностью от 55 до 120 л.с. Транспортировка грунта при этом может осуществляться со скоростью до 40 км/час. Модель имеет регулируемую принудительную разгрузку за счет выдвижения задней стенки ковша от гидроцилиндра. Он имеет гидравлическое управление заглублением, подъем (опускание) передней стенки, разгрузкой и поворотом колес, которое осуществляется в ручном или в автоматическом режиме. С помощью выталкивающего устройства с гидравлическим приводом грунт подается перед планировочным отвалом и сразу же укладывается.

Он имеет гидравлическое управление заглублением, подъем (опускание) передней стенки, разгрузкой и поворотом колес, которое осуществляется в ручном или в автоматическом режиме. С помощью выталкивающего устройства с гидравлическим приводом грунт подается перед планировочным отвалом и сразу же укладывается.

Для работы гидросистемы скрепера необходим трактор, имеющий четыре гидролинии: первую — для заглубления ножа, вторую — для открытия передней стенки ковша, третью — для движения задней стенки ковша при разгрузке и, наконец, четвертую — для управления поворотом колес. При наличии лишь трех гидролиний на тракторе последнюю можно отключить.

Ширина полосы скреперования у этой модели составляет 1480 миллиметров. Собственный вес прицепного агрегата — 1000 килограммов, длина J20 — 4000 миллиметров, высота — 1200 миллиметров.

Опционально этот компактный скрепер может поставляться с автоматизированной системой нивелирования, пилотируемой лазером или GPS, которая обеспечивает повышенную надежность и точность. Впрочем, возможны три различных варианта управления скрепером.

Впрочем, возможны три различных варианта управления скрепером.

Первый из них — стандартный, описанный выше, при котором гидросистема скрепера подключается к гидросистеме трактора, управление осуществляется из кабины с помощью рычагов управления дополнительным оборудованием. Второй вариант подразумевает автоматическое управление: гидросистема оборудования также подключена к гидросистеме трактора, а на исполнительные механизмы гидросистемы дополнительно устанавливается оборудование для управления от лазера или GPS; управление в этом случае осуществляется от лазерной системы нивелирования в автоматическом режиме. И, наконец, автономное управление — оно целесообразно при работе в связке с трактором, у которого нет своей гидросистемы для питания дополнительного рабочего управления либо же в том случае, когда ее параметры не обеспечивают эффективную работу скрепера. В этом случае последний дополнительно комплектуется гидронасосом, который устанавливается на ВОМ трактора. На раму скрепера устанавливается автономный гидробак, кроме того, техника комплектуется пультом управления. В данном исполнении скрепер также может комплектоваться автоматической системой управления для работы от системы нивелирования.

В данном исполнении скрепер также может комплектоваться автоматической системой управления для работы от системы нивелирования.

Именно компактные прицепные скреперы, вроде описанного выше Montefiori J20 или чуть более вместительного J25 той же марки, имеют пусть небольшой, но стабильный спрос на разных рынках. Что касается более габаритной техники, прицепной или самоходной, ее продажи во всем мире год от года снижаются — и вопрос только в порядке цифр. Если на европейском рынке ежегодно продается не более двух десятков скреперов, то на североамериканском — около сотни. Связано это прежде всего с высоким уровнем укомплектованности парка строительных (включая дорожно-строительные) компаний более распространенной техникой, с ее помощью можно выполнить работу, для которой изначально был создан скрепер: фронтальными ковшовыми погрузчиками, экскаваторами-погрузчиками, экскаваторами, грейдерами, бульдозерами и самосвалами. Что касается добычи полезных ископаемых, здесь на смену скреперам все чаще приходит интеллектуальная техника вроде карьерных комбайнов. Одни виды техники отживают свое, и их сменяют другие — это закономерный процесс для мира машин, включая и землеройно-транспортные их разновидности.

Одни виды техники отживают свое, и их сменяют другие — это закономерный процесс для мира машин, включая и землеройно-транспортные их разновидности.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Скрепер для уборки снега Центроинструмент металлический 600×600 1612 – цена, отзывы, характеристики, фото

- Ширина, мм 600

- Материал корпуса нержавеющая сталь

- Конструкция нескладная

- Материал черенка сталь

- Ручка/черенок в комплекте есть org/PropertyValue”> Тип для снега

- Вес, кг 4

- Габариты, мм 600х600

- Ручка на черенке нет

- Длина рабочей части, мм 600

- Разборная нет

- Показать еще

Этот товар из подборок

Параметры упакованного товара

Единица товара: Штука

Вес, кг: 6,20

Длина, мм: 1300

Ширина, мм: 290

Высота, мм: 290

Произведено

- Россия — родина бренда

- Тайвань — страна производства*

- Информация о производителе

Указанная информация не является публичной офертой

На данный момент для этого товара нет расходных материалов4 способа очистки изображений с веб-страниц или веб-сайтов

Видеоурок: парсинг и массовая загрузка изображений с любого веб-сайта

Содержание

Используйте браузер

Используйте клиентский инструмент для очистки веб-страниц

Для программистов и …

Видеоурок

На фотоплатформах, таких как Instagram и Pinterest, так много фантастических изображений, а на сайтах электронной коммерции – неограниченное количество фотографий продуктов, которые могут вдохновить ваш бизнес.Эта статья покажет вам, как эффективно загружать или очищать изображения с веб-сайтов.

Я расскажу вам 4 способа очистки изображений до локального файла. По мере чтения вы увидите, как легко получить нужные изображения за несколько кликов.

Приступим!

Используйте инструмент браузера для очистки изображений 1. Если на вашем компьютере установлен Firefox , вы можете быть удивлены тем, что все происходит сразу после щелчка правой кнопкой мыши.Вы можете скачать все изображения с данного веб-сайта, выполнив следующие действия. Через несколько секунд.Откройте веб-сайт, с которого вы собираетесь получать изображения, с помощью Firefox. Щелкните правой кнопкой мыши пустую область, и вы увидите опцию «просмотреть информацию о странице». Щелкните по нему.

Вот всплывающее окно «Информация о странице».

Пропустите общую информацию и щелкните «Медиа». Вы увидите список URL-адресов тех изображений, которые вы собираетесь загрузить. Нажмите «выбрать все» – «Сохранить как»: теперь вы получаете все изображения с веб-сайта!

Нажмите «выбрать все» – «Сохранить как»: теперь вы получаете все изображения с веб-сайта!

Откройте веб-сайт, с которого хотите удалить изображения. Запустите инструмент расширения, и вы обнаружите, что этот инструмент предлагает фильтр, который поможет вам избавиться от этих маленьких крошечных значков и загрузить только те изображения нормального размера, которые вам нужны.

3. Забудьте о том, какой браузер вы используете. – это веб-инструмент для массовой загрузки изображений с веб-сайта: IMAGE CYBORG.Эти методы могут помочь вам загрузить изображения целевого веб-сайта за секунды. Подходит для загрузки одной страницы. Хотя, если вы хотите очистить изображения с ряда страниц сайта или помимо изображений, вам также понадобится набор данных, связанных с каждым изображением (например, чтобы найти название продукта и цену изображения продукта) , для удобства извлечения данных вам следует обратиться к инструменту для очистки веб-страниц.

Используйте клиентский инструмент для очистки веб-страниц, чтобы очистить не только изображения 4. Если вас не устраивает надежная одностраничная загрузка , вы можете испытать себя с помощью инструмента для очистки веб-страниц (здесь в качестве примера используется Octoparse), и я уверен, что вам это понравится.

Используйте клиентский инструмент для очистки веб-страниц, чтобы очистить не только изображения 4. Если вас не устраивает надежная одностраничная загрузка , вы можете испытать себя с помощью инструмента для очистки веб-страниц (здесь в качестве примера используется Octoparse), и я уверен, что вам это понравится.В отличие от одностраничного загрузчика изображений, инструмент парсинга поможет вам получить URL-адреса необходимых изображений. И как только вы получите все URL-адреса, вы можете просто загрузить изображения на свой компьютер.

Когда следует использовать Octoparse для очистки изображений?

- «Я собираюсь очистить изображения, занимающие множество страниц»

Используя Octoparse для очистки изображений, вы можете добавить поисковому роботу разбиение на страницы, чтобы он мог автоматически очищать URL-адреса изображений на множестве страниц. Вместо того, чтобы загружать изображения постранично с помощью инструмента расширения, Octoparse может сэкономить вам много времени.

Вместо того, чтобы загружать изображения постранично с помощью инструмента расширения, Octoparse может сэкономить вам много времени.

- «Я собираюсь очистить изображения на множестве экранов»

Google Images с бесконечной прокруткой

Вместо разбивки на страницы в Картинках Google используется бесконечная прокрутка, и пользователи должны прокручивать страницу вниз, чтобы активировать загрузку нового контента. Может ли инструмент для очистки загрузить все изображения перед запуском процесса?

Да, Octoparse имеет встроенный браузер, который имитирует человеческую деятельность и визуализирует процесс.Вы можете настроить браузер на прокрутку вниз до начала очистки.

- «Мне нужны не только изображения, но и другая информация, связанная с ними»

Людей, занимающихся исследованием товаров в электронной торговле, не удовлетворят только изображения товаров. Они должны изучить не только внешний вид и дизайн продукта, но также цены и другие параметры, чтобы оценить его общие характеристики.

Они должны изучить не только внешний вид и дизайн продукта, но также цены и другие параметры, чтобы оценить его общие характеристики.

Данные получены с Amazon с использованием шаблонов Octoparse

Octoparse предлагает пользователям шаблоны для парсинга с ряда веб-сайтов, таких как Amazon, Yelp, Booking и т. Д.В этом случае вы можете очистить не только URL-адреса изображений, но и другую информацию о продукте, ресторане или отеле.

Теперь, когда у вас есть два доступных набора данных (изображения и соответствующая подробная информация), которые соответствуют друг другу, вы получаете небольшую базу данных продуктов и можете начать свое исследование!

Хотите массово загрузить тысячи изображений? Это видео представляет собой обучающее видео, которое дает пошаговое руководство, которое поможет пользователям очистить и загрузить изображения с Aliexpress с помощью Octoparse. Когда вы освоитесь с инструментом, вы сможете без труда скачивать изображения с любых сайтов!

Когда вы освоитесь с инструментом, вы сможете без труда скачивать изображения с любых сайтов!

Если вы программист или …

Если вы программист или хотите пойти дальше, чтобы увидеть, как очищать изображения с веб-сайтов, python может стать классическим способом достичь цели.Как насчет того, чтобы начать для этого небольшой scrapy-проект?

Автор: Cici

Как очистить URL-адреса изображений, которые увеличиваются при наведении курсора

Как создать сканер изображений без программирования

Как массово загрузить изображения с веб-сайта?

Youtube: массовая загрузка изображений с веб-сайтов с помощью Octoparse

Лучший веб-скребок для Mac: парсинг данных с любого веб-сайта

Как очищать и загружать изображения с любого веб-сайта

Загрузка большого количества изображений с веб-сайта может занять довольно много времени.

Щелкните правой кнопкой мыши, «Сохранить изображение как…», повторяйте до тошноты.

В таких случаях поиск веб-страниц – это решение вашей проблемы. В этом руководстве мы рассмотрим, как извлечь URL-адрес для каждого изображения на веб-странице с помощью бесплатного парсера.

Мы также рассмотрим, как использовать этот извлеченный список для быстрой загрузки всех изображений на ваш компьютер.

Не стесняйтесь щелкать любую ссылку, чтобы перейти к определенной части руководства.

ParseHub и веб-парсинг

Для выполнения этой простой задачи вам понадобится веб-скребок, который может собирать URL-адреса. обсуждаемый.ParseHub – бесплатный и невероятно мощный веб-скребок, идеальный кандидат для этой задачи.

Не забудьте загрузить и установить ParseHub перед началом работы.

Очистка URL-адресов изображений

В этом примере мы предположим, что мы заинтересованы в загрузке каждого изображения для первых 5 страниц результатов на Amazon. ca для «беспроводных наушников». Эта информация потенциально может быть невероятно ценной для анализа конкурентов.

ca для «беспроводных наушников». Эта информация потенциально может быть невероятно ценной для анализа конкурентов.

Начало работы

- После загрузки ParseHub убедитесь, что он запущен на вашем компьютере.

- Получите конкретный URL страницы, которую мы будем очищать.

Создание проекта

- В ParseHub щелкните «Новый проект» и введите URL-адрес веб-сайта Amazon, который мы будем сканировать.

- Веб-страница теперь будет отображаться в ParseHub, и вы сможете выбрать изображения, которые хотите очистить.

Выберите изображения для очистки

- Начните с выбора первого изображения в результатах поиска.Затем он станет зеленым, что означает, что он был выбран для очистки.

- Остальные изображения на странице результатов поиска станут желтыми.

Щелкните второе изображение, чтобы выбрать все изображения на странице. Все они станут зелеными, что означает, что они были выбраны для извлечения.

Щелкните второе изображение, чтобы выбрать все изображения на странице. Все они станут зелеными, что означает, что они были выбраны для извлечения.

- Поскольку эти изображения также действуют как ссылки на страницы продуктов, ParseHub извлекает как URL изображения, так и ссылку, на которую оно указывает (страница продукта).В результате мы удалим выделение URL-адреса на левой боковой панели и сохраним только выделенное изображение.

- Теперь ParseHub будет очищать каждый URL-адрес изображения для первой страницы результатов.

Теперь нам нужно указать ParseHub извлечь ту же информацию, но для следующих 5 страниц результатов поиска.

- Щелкните значок ПЛЮС (+) рядом с выбором на странице и используйте команду выбора.

- Затем нажмите кнопку «Далее» и внизу страницы результатов поиска.

- По умолчанию ParseHub извлекает ссылку из кнопки «Далее». Итак, мы щелкнем значок рядом с выбором «Далее» и удалим два элемента под ним.

- Затем мы воспользуемся знаком ПЛЮС (+) рядом с выбором «следующий» и воспользуемся командой «щелкнуть».

- Появится окно с вопросом, является ли это ссылкой на следующую страницу.Нажмите «Да» и введите количество повторов этого цикла. В этом примере мы сделаем это 5 раз.

Очистка и экспорт данных

А теперь самое интересное. Мы позволим ParseHub запустить и извлечь список URL-адресов для каждого выбранного изображения.

- Нажмите кнопку «Получить данные» на левой боковой панели.

- Здесь вы можете выбрать, когда запускать парсинг. Хотя мы всегда советуем тестировать циклы очистки перед запуском полной очистки, мы просто запустим ее прямо сейчас для этого примера.

- Теперь ParseHub очистит URL-адрес изображения, который вы выбрали. Вы можете либо подождать на этом экране, либо покинуть ParseHub, вы получите уведомление, когда очистка будет завершена. В данном случае этот процесс занял менее 1 минуты.

- Когда ваши данные будут готовы к загрузке, нажмите кнопку CSV / Excel. Теперь вы можете сохранить и переименовать свой файл.

Загрузите изображения на свое устройство

Теперь, когда у нас есть список всех URL-адресов для каждого изображения, мы продолжим и загрузим их на свое устройство с помощью одного простого инструмента.

Для этого мы будем использовать расширение Chrome для сохранения вкладки.

После установки в браузере откройте расширение, щелкнув его значок. Это откроет расширение, затем нажмите кнопку редактирования в левом нижнем углу, чтобы ввести только что извлеченные URL-адреса.

Если щелкнуть значок загрузки в правом нижнем углу окон расширений, все изображения будут автоматически загружены на ваше устройство. Это может занять пару секунд в зависимости от того, сколько изображений вы загружаете.

Это может занять пару секунд в зависимости от того, сколько изображений вы загружаете.

Последние мысли

Выполняя каждый шаг в этом руководстве, у вас будет папка со всеми изображениями, которые необходимо загрузить. В этом случае мы загрузили более 330 изображений с Amazon менее чем за 5 минут.

А теперь, извините, мне нужно удалить все эти изображения с жесткого диска.

Загрузите ParseHub бесплатно сегодня

Вам также может быть интересно прочитать другие практические руководства:

Или, может быть, вы были бы заинтересованы в получении сертификата парсинга веб-страниц? Пройдите БЕСПЛАТНЫЕ курсы по веб-парсингу и получите сертификат уже сегодня!

Обработка изображений с помощью Python.Руководство с кодом, чтобы узнать, как… | Фабиан Бослер

Фото Росс Финдон на Unsplash Однако большинство современных веб-страниц довольно интерактивны. Концепция «одностраничного приложения» означает, что сама веб-страница будет изменяться без необходимости перезагрузки пользователю или постоянного перенаправления со страницы на страницу. Поскольку это происходит только после определенного взаимодействия с пользователем, есть несколько вариантов, когда дело доходит до очистки данных (поскольку эти действия действительно должны иметь место).

Поскольку это происходит только после определенного взаимодействия с пользователем, есть несколько вариантов, когда дело доходит до очистки данных (поскольку эти действия действительно должны иметь место).

Иногда действие пользователя может вызвать вызов открытого серверного API.В этом случае можно было бы получить прямой доступ к API и получить полученные данные без необходимости выполнять ненужные промежуточные шаги. Однако в большинстве случаев вам придется выполнять шаги по нажатию кнопок, прокрутке страниц, ожиданию загрузки и тому подобное … или, по крайней мере, вам нужно заставить веб-страницу думать, что вы, , делаете все это. Селен спешит на помощь!

Selenium

Selenium можно использовать для автоматизации взаимодействия веб-браузера с Python (также другими языками).Выражаясь непрофессиональным языком, селен притворяется настоящим пользователем, он открывает браузер, «перемещает» курсор и нажимает кнопки, если вы ему прикажете. Насколько мне известно, первоначальная идея Selenium – автоматическое тестирование. Однако Selenium столь же эффективен, когда дело доходит до автоматизации повторяющихся веб-задач.

Однако Selenium столь же эффективен, когда дело доходит до автоматизации повторяющихся веб-задач.

Давайте рассмотрим пример, чтобы проиллюстрировать использование Selenium. К сожалению, заранее требуется небольшая подготовка. Я опишу установку и использование Selenium с Google Chrome. Если вы хотите использовать другой браузер (например, Headless), вам необходимо загрузить соответствующий WebDriver. Вы можете найти больше информации здесь.

Шаги:

- Установите Google Chrome (пропустите, если он уже установлен)

- Определите вашу версию Chrome. Обычно его можно найти, нажав «О Google Chrome». В настоящее время у меня есть версия 77.0.3865.90 (моя основная версия, таким образом, 77 , число перед первой точкой).

- Загрузите отсюда соответствующий ChromeDriver для вашей основной версии и поместите исполняемый файл в доступное место (я использую

Desktop / Scraping) - Установите пакет Python Selenium через

pip install selenium

Запуск WebDriver

Запустите следующий фрагмент (для простоты демонстрации сделайте это в Jupyter Notebook) и посмотрите, как открывается призрачный браузер.

import selenium # Это путь, который я использую

# DRIVER_PATH = '... / Desktop / Scraping / chromedriver 2' # Поместите путь для вашего ChromeDriver сюда

DRIVER_PATH =wd = webdriver.Chrome (executable_path = DRIVER_PATH)

Если все пойдет по плану, вы должны увидеть что-то вроде этого:

Браузер Google Chrome, управляемый SeleniumТеперь запустите (в новой ячейке):

wd.get ('https://google.com' ) Ваш браузер должен перейти – что неудивительно – в Google.com. Теперь запустите:

search_box = wd.find_element_by_css_selector ('input.gLFyf')

search_box.send_keys ('Dogs') Вы увидите результат, когда ваш браузер наберет Dogs в поле поиска.

Хорошо, закроем драйвер:

wd.quit ()

Отлично! Вы знаете основы. Selenium чрезвычайно мощный инструмент, и практически любое взаимодействие можно смоделировать. Некоторые действия доступны даже с помощью абстрактных методов, таких как нажатие кнопок или наведение курсора на объекты. Кроме того, в худшем случае вы всегда можете вернуться к имитации человеческого поведения, переместив курсор туда, где вы хотите, а затем выполнить действие щелчка.

Кроме того, в худшем случае вы всегда можете вернуться к имитации человеческого поведения, переместив курсор туда, где вы хотите, а затем выполнить действие щелчка.

скребок изображений – npm

Это простой способ очистить изображения Google с помощью Puppeteer. Безголовый браузер будет вести себя как «обычный» пользователь и будет прокручивать страницу вниз, пока не будет достаточно результатов.

Обратите внимание, что это не идеальный подход для очистки изображений. Это всего лишь демонстрация очистки изображений от Google.Если вас не волнует источник, вероятно, лучше использовать другую поисковую систему с API, например Bing.

npm установка скребка образов

Дайте мне первые 200 изображений Banana из Google (в браузере без головы)

var Scraper = require ('images-scraper');

const google = new Scraper ({

кукловод: {

без головы: ложь,

},

});

(async () => {

const results = await google. scrape ('банан', 200);

приставка.журнал ('результаты', результаты);

}) ();

scrape ('банан', 200);

приставка.журнал ('результаты', результаты);

}) (); Результатов

узел src / example.js

результатов [

{

url: 'https://api.time.com/wp-content/uploads/2019/11/gettyimages-459761948.jpg?quality=85&crop=0px%2C74px%2C1024px%2C536px&resize=1200%2C628&strip',

источник: 'https://time.com/5730790/banana-panama-disease/',

title: «Чему мы можем научиться из почти полного исчезновения бананов | Время'

},

...

] Конструктору можно передать несколько параметров.

var options = {

userAgent: 'Mozilla / 5.0 (X11; Linux i686; rv: 64.0) Gecko / 20100101 Firefox / 64.0', // пользовательский агент

puppeteer: {}, // параметры кукольника, например, {headless: false}

tbs: {// все возможные варианты поиска tbs, некоторые примеры и дополнительная информация: http://jwebnet.net/advancedgooglesearch.html

isz: // параметры: l (arge), m (edium), i (cons) и т. д.

itp: // параметры: клипарт, лицо, штриховой рисунок, новости, фото

ic: // параметры: цвет, серый, транс

sur: // параметры: fmc (коммерческое повторное использование с модификацией), fc (коммерческое повторное использование), fm (некоммерческое повторное использование с модификацией), f (некоммерческое повторное использование)

},

safe: false // включить / отключить безопасный поиск

}; Пример для форка: https: // repl. это / присоединиться / hylyxvxc-peterevers

это / присоединиться / hylyxvxc-peterevers

Запуск этого на Repl.it требует, чтобы вы создали ответ Bash вместо ответа NodeJS. Создание реплики Bash предоставит вам зависимость Chromium.

Чтобы использовать эти пакеты в Heroku, установите https://elements.heroku.com/buildpacks/jontewks/puppeteer-heroku-buildpack. Тогда беги.

npm config set puppeteer_download_host = https: //npm.taobao.org/mirrors

И переустановите Puppeteer.

Отладку можно выполнить, отключив безголовый браузер и визуально изучив предпринятые действия.

const google = new Scraper ({

кукловод: {

без головы: ложь,

},

}); Или настройками переменной окружения LOG_LEVEL .

LOG_LEVEL = узел отладки src / example.js .

Авторские права (c) 2021, Питер Эверс [email protected]

Настоящим предоставляется разрешение на использование, копирование, изменение и / или распространение этого программного обеспечения для любых целей за плату или без комиссии при условии, что указанное выше уведомление об авторских правах и это уведомление о разрешении присутствуют во всех копиях. ПРОГРАММНОЕ ОБЕСПЕЧЕНИЕ ПРЕДОСТАВЛЯЕТСЯ «КАК ЕСТЬ», И АВТОР ОТКАЗЫВАЕТСЯ ОТ ВСЕХ ГАРАНТИЙ В ОТНОШЕНИИ ДАННОГО ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ, ВКЛЮЧАЯ ВСЕ ПОДРАЗУМЕВАЕМЫЕ ГАРАНТИИ КОММЕРЧЕСКОЙ ЦЕННОСТИ И ПРИГОДНОСТИ. НИ ПРИ КАКИХ ОБСТОЯТЕЛЬСТВАХ АВТОР НЕ НЕСЕТ ОТВЕТСТВЕННОСТИ ЗА ЛЮБЫЕ ОСОБЫЕ, ПРЯМЫЕ, КОСВЕННЫЕ ИЛИ КОСВЕННЫЕ УБЫТКИ ИЛИ ЛЮБЫЕ УБЫТКИ, ПРИЧИНЕННЫЕ В РЕЗУЛЬТАТЕ ИСПОЛЬЗОВАНИЯ, ДАННЫХ ИЛИ ПРИБЫЛИ, В РЕЗУЛЬТАТЕ ДЕЙСТВИЯ ДОГОВОРА, НЕЗАВИСИМОСТИ ИЛИ ИНЫХ ДЕЙСТВИЙ В СВЯЗИ С ИСПОЛЬЗОВАНИЕМ ИЛИ ВЫПОЛНЕНИЕМ ДАННОГО ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ.

ПРОГРАММНОЕ ОБЕСПЕЧЕНИЕ ПРЕДОСТАВЛЯЕТСЯ «КАК ЕСТЬ», И АВТОР ОТКАЗЫВАЕТСЯ ОТ ВСЕХ ГАРАНТИЙ В ОТНОШЕНИИ ДАННОГО ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ, ВКЛЮЧАЯ ВСЕ ПОДРАЗУМЕВАЕМЫЕ ГАРАНТИИ КОММЕРЧЕСКОЙ ЦЕННОСТИ И ПРИГОДНОСТИ. НИ ПРИ КАКИХ ОБСТОЯТЕЛЬСТВАХ АВТОР НЕ НЕСЕТ ОТВЕТСТВЕННОСТИ ЗА ЛЮБЫЕ ОСОБЫЕ, ПРЯМЫЕ, КОСВЕННЫЕ ИЛИ КОСВЕННЫЕ УБЫТКИ ИЛИ ЛЮБЫЕ УБЫТКИ, ПРИЧИНЕННЫЕ В РЕЗУЛЬТАТЕ ИСПОЛЬЗОВАНИЯ, ДАННЫХ ИЛИ ПРИБЫЛИ, В РЕЗУЛЬТАТЕ ДЕЙСТВИЯ ДОГОВОРА, НЕЗАВИСИМОСТИ ИЛИ ИНЫХ ДЕЙСТВИЙ В СВЯЗИ С ИСПОЛЬЗОВАНИЕМ ИЛИ ВЫПОЛНЕНИЕМ ДАННОГО ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ.

Селектор изображений | Документация по веб-парсеру

Селектор изображений может извлекать атрибут src (URL) изображения.

Примечание! При выборе селектора CSS для селектора изображений все изображения в сайт перемещен в топ. Если эта функция каким-то образом нарушает верстку сайтов, пожалуйста сообщить об этом как об ошибке.

Варианты конфигурации

- selector – CSS-селектор для элемента изображения.

- multiple – извлекается несколько записей. Обычно не должно быть проверил селектор изображений.

Сценарии использования

См. Сценарии использования селектора текста.

Скрипт загрузчика изображений

Скрипт загрузчика изображений находит URL-адреса изображений, извлеченные программой Image Selector, в файле csv и загружает их.Он попытается загрузить изображения со всех URL-адресов, которые хранятся в столбцах,

имена заканчиваются на -src . web-scraper-oder и web-scraper-start-url Столбцы требуется для работы скрипта. Изображения переименованы в <веб-скребок> - <имя-селектора> .ext .

Использование Windows

- Загрузите и установите python 3.x отсюда: https://www.python.org/downloads/

- Загрузите скрипт загрузчика изображений отсюда: https: // github.com / webscraperio / image-downloader

- Очистите целевой сайт и экспортируйте данные в формате CSV

- Перетащите CSV-файл поверх

image-downloader. py

py

macOS, использование Linux

- При необходимости установите python через диспетчер пакетов. Скорее всего, он у вас уже предустановлен.

- Загрузите скрипт загрузчика изображений отсюда: https://github.com/webscraperio/image-downloader

- Move

загрузчик изображений.pytoЗагрузкикаталог - Очистите целевой сайт и экспортируйте данные в формате CSV

- Сохраните файл CSV в каталоге

Загрузки - Откройте приложение

Терминал. У вас должен быть один предустановленный - Перейдите в рабочий каталог

Загрузки, набрав:cd Загрузки - Запустите сценарий загрузки изображений, набрав:

Python image-downloader.py scraped_data.csv

Очистка Интернета – мощный инструмент.Clearview AI Abused It

Интернет был разработан, чтобы сделать информацию бесплатной и простой для всех. Но по мере того, как объем личной информации в Интернете растет, риски тоже возрастают. На прошлых выходных для многих защитников конфиденциальности произошел кошмарный сценарий. New York Times сообщила, что Clearview AI, секретная компания по наблюдению, продавала правоохранительным органам инструмент распознавания лиц, основанный на «трех миллиардах изображений», взятых из открытого Интернета. Копы уже давно имеют доступ к подобной технологии, но Clearview отличается тем, где она получает свои данные.По данным Times , компания скопировала изображения с миллионов общедоступных сайтов, включая Facebook, YouTube и Venmo.

Но по мере того, как объем личной информации в Интернете растет, риски тоже возрастают. На прошлых выходных для многих защитников конфиденциальности произошел кошмарный сценарий. New York Times сообщила, что Clearview AI, секретная компания по наблюдению, продавала правоохранительным органам инструмент распознавания лиц, основанный на «трех миллиардах изображений», взятых из открытого Интернета. Копы уже давно имеют доступ к подобной технологии, но Clearview отличается тем, где она получает свои данные.По данным Times , компания скопировала изображения с миллионов общедоступных сайтов, включая Facebook, YouTube и Venmo.

Чтобы использовать этот инструмент, полицейские просто загружают изображение подозреваемого, а Clearview выводит его фотографии и ссылки на то, где они были размещены. Компания упростила возможность мгновенно подключить человека к его следу в сети – именно этой способностью многие люди давно опасались, что кто-то будет обладать этой способностью. (К заявлениям Clearview следует относиться с недоверием; расследование Buzzfeed News показало, что его маркетинговые материалы содержат преувеличения и ложь.Компания не сразу ответила на запрос о комментарии.)

(К заявлениям Clearview следует относиться с недоверием; расследование Buzzfeed News показало, что его маркетинговые материалы содержат преувеличения и ложь.Компания не сразу ответила на запрос о комментарии.)

Как практически любой инструмент, соскабливание может использоваться в благородных или гнусных целях. Без него у нас не было бы, например, бесценной WayBack Machine из Internet Archive. Но это также то, как исследователи из Стэнфорда несколько лет назад создали широко осуждаемый «гайдар», алгоритм, который, по их утверждениям, может определять сексуальность человека по его лицу. «Это фундаментальная вещь, на которую мы полагаемся каждый день, многие люди даже не подозревают, потому что это происходит за кулисами», – говорит Джейми Ли Уильямс, штатный поверенный Electronic Frontier Foundation из группы гражданских свобод.EFF и другие группы по защите цифровых прав часто утверждали, что преимущества выскабливания перевешивают вред.

ПОДРОБНЕЕ

Автоматический скрапинг нарушает политики таких сайтов, как Facebook и Twitter, последний из которых специально запрещает парсинг для создания баз данных распознавания лиц. На этой неделе Twitter отправил Clearview письмо с просьбой прекратить кражу данных с сайта «по любой причине», и Facebook, как сообщается, также изучает этот вопрос, согласно Times .Но неясно, есть ли у них какие-либо средства правовой защиты в нынешней системе.

На этой неделе Twitter отправил Clearview письмо с просьбой прекратить кражу данных с сайта «по любой причине», и Facebook, как сообщается, также изучает этот вопрос, согласно Times .Но неясно, есть ли у них какие-либо средства правовой защиты в нынешней системе.

Чтобы противостоять скрапингу, компании часто использовали Закон о компьютерном мошенничестве и злоупотреблениях, утверждая, что эта практика равносильна доступу к компьютеру без надлежащего разрешения. Однако в прошлом году Девятый окружной апелляционный суд постановил, что автоматический сбор данных не нарушает CFAA. В этом случае LinkedIn подала в суд и проиграла компанию HiQ, которая массово очищала общедоступные профили LinkedIn и объединяла их с другой информацией в базу данных для работодателей.EFF и другие группы объявили решение о победе, поскольку оно ограничивало сферу действия CFAA, которым, по их мнению, часто злоупотребляли компании, и помогло защитить исследователей, нарушающих условия соглашения во имя свободы информации.

CFFA – один из немногих вариантов, доступных компаниям, которые хотят остановить скреперы, что является частью проблемы. «Это закон 1986 года, еще до появления Интернета, – говорит Уиллиамс. «Если это лучшее, что мы можем сделать для защиты нашей конфиденциальности от этих очень сложных, очень современных проблем, то я думаю, что мы облажались.

Группы за гражданские свободы и технологические компании призывают к принятию федерального закона, который установит право американцев на неприкосновенность частной жизни в цифровую эпоху. Clearview и компании, которым это нравится, делают этот вопрос более срочным. «Нам нужен всеобъемлющий закон о конфиденциальности, охватывающий биометрические данные», – говорит Уильямс.

Обработка изображений с помощью Python

Процесс создания приложений машинного обучения, глубокого обучения или искусственного интеллекта состоит из нескольких этапов. Один из них – анализ данных и определение того, какие из них можно использовать, а какие нет. Нам также нужно выбрать алгоритмы машинного обучения или архитектуры нейронной сети , которые нам нужно использовать для решения проблемы. Мы можем даже использовать обучение с подкреплением или трансферное обучение. Однако часто у клиентов нет данных, которые могли бы решить их проблему. Чаще всего это , наша задача – получить данные из Интернета, которые будут использоваться алгоритмом машинного обучения или нейронной сетью .

Нам также нужно выбрать алгоритмы машинного обучения или архитектуры нейронной сети , которые нам нужно использовать для решения проблемы. Мы можем даже использовать обучение с подкреплением или трансферное обучение. Однако часто у клиентов нет данных, которые могли бы решить их проблему. Чаще всего это , наша задача – получить данные из Интернета, которые будут использоваться алгоритмом машинного обучения или нейронной сетью .

Обычно это правило, когда мы работаем над задачами компьютерного зрения.Клиенты полагаются на вашу способность собирать данные, которые будут использоваться для ваших VGG , ResNet или пользовательской сверточной нейронной сети. Итак, в этой статье мы сосредоточимся на этапе, предшествующем анализу данных, и всем модным алгоритмам – очистке данных, или, если быть точнее, очистке изображений. Мы собираемся выяснить два способа получить изображения с какого-нибудь веб-сайта с помощью Python.

Технологии

В общем, существует несколько способов загрузки изображений с веб-страницы.Есть даже несколько пакетов Python , которые могут помочь вам с этой задачей. В этой статье мы исследуем , два из этих пакетов: Beautiful Soup, и Scrapy. Обе хорошие библиотеки для извлечения данных из HTML .

Чтобы установить их, запустите эту команду для Beautiful Soup :

pip install beautifulsoup4

И эта команда для Scrapy:

pip install scrapy

Поскольку эти инструменты не могут работать без Pillow , убедитесь, что эта библиотека также установлена :

pip install Подушка